Artículo publicado en la Revista T de junio, que se consigue en los kioscos.

Hace cerca de 60 años, en 1959, el filósofo Günther Anders, conmovido por las bombas de Hiroshima y Nagasaki, se refirió a su tiempo como uno marcado por la conciencia de la posibilidad efectiva del Final: la autoextinción de la humanidad. Podríamos llamarnos utopistas invertidos escribió en sus Tesis sobre la era atómica: mientras que los utopistas corrientes son incapaces de producir realmente lo que pueden imaginar, nosotros somos incapaces de imaginar lo que realmente estamos produciendo.

Hoy podríamos afirmar lo mismo, con la diferencia de que en este tiempo lo que nos cuesta concebir es nuestro poder no únicamente de (auto)destrucción sino también de desciframiento, manipulación e incluso producción de lo viviente, algo que se realiza a diario a través de intervenciones tecnológicas cada vez más audaces.

Esta dificultad para reflexionar sobre lo que hacemos no arraiga tanto en el hecho de que las investigaciones científicas y los desarrollos tecnológicos se despliegan a nuestras espaldas de ciudadanos comunes. Si bien esto es en alguna medida cierto, también lo es que, en muchos casos, están tan a la vista que tendemos a naturalizarlos. Vivimos, sin duda, con más gadgets tecnológicos a nuestro alrededor que cualquier otra generación precedente. Incorporamos tecnologías a nuestro cuerpo en forma de prótesis e implantes, las utilizamos en trasplantes, cirugías plásticas y reparadoras, convivimos con aparatos inteligentes que nos asisten en cada acción: buscar una receta de cocina, movernos en una ciudad, organizar un presupuesto, comprar un libro, arreglar un estante flojo, traducir un documento, entre muchas otras tareas. Nos permiten conocemos mejor a nosotros mismos (a través de estudios como los diagnósticos genéticos o las tomografías computadas), delegamos en ellas decisiones fundamentales (como en las transacciones bursátiles que prescinden de la intervención humana: los robots de la negociación de alta frecuencia que, según Irene Aldridge y Steven Krawciw, autores del libro Riesgo en tiempo real, tuvieron a su cargo cerca del 30% de las operaciones efectuadas en 2016), realizamos con máquinas las actividades productivas más significativas, nos comunicamos a través de ellas, nos divertimos con ellas.

Ahora bien: cuando todos los días se nos dice que estamos ante innovaciones espectaculares, ¿qué es lo realmente nuevo en la tecnología de nuestro tiempo? Sintéticamente, podríamos mencionar cuatro grandes campos o grupos de procesos, que apuntan al núcleo duro de nuestra experiencia como especie.

El primero está vinculado al desarrollo de máquinas que tienen la capacidad de aprender de manera automática, o machine learning. Es decir, programas que desarrollan acciones no solo a partir de instrucciones contenidas previamente, sino que incorporan nueva información que aparece durante el proceso. Esta rama de la Inteligencia Artificial tiene una gama vastísima de aplicaciones: desde motores de búsqueda, robótica y diagnósticos médicos hasta predicción de los gustos de los usuarios a partir de sus datos de navegación pasando por la detección de fraude en el uso de tarjetas de crédito, o el reconocimiento del lenguaje escrito y del habla, entre otras. Un ejemplo a la mano lo tenemos en los equipos GPS que proponen una ruta: si el conductor toma un buen atajo, el aparato aprende de esta nueva información, afinando la próxima sugerencia. Su desarrollo obedece al interés por comprender, expandir y asistir a la mente humana.

El segundo gran grupo es el de las tecnologías de la vida: los últimos desarrollos de las biotecnologías, ciertas áreas de la medicina, la biología molecular y la ingeniería de sistemas biológicos. Incluye desde la obtención de organismos para la producción de antibióticos hasta el desarrollo de semillas transgénicas, pasando por la obtención de elementos semi-vivos, esto es, material biológico humano sostenido con vida mediante una intervención tecnológica intensiva, originalmente extraído de un cuerpo o producido de manera artificial. Proliferan así los biobancos: bancos de sangre, esperma, células madre, datos genéticos, que almacenan material biológico y su información asociada. También se cultivan células o tejidos, y se desarrollan artificialmente partes del cuerpo que se imprimen en 3D. Hasta ahora se han implantado fragmentos de mandíbula, de tráquea, incluso en 2014 cirujanos holandeses implantaron con éxito un cráneo impreso en 3D a una joven de 22 años que sufría una dolencia que había añadido cinco centímetros a los huesos de su cabeza. Si bien hace tiempo se viene anunciando el desarrollo de órganos enteros, esto está todavía en exploración. El despliegue de este campo obedece al interés por comprender y expandir la biología natural, así como intervenir optimizando el cuerpo humano.

PANTALLAS Y BIG DATA

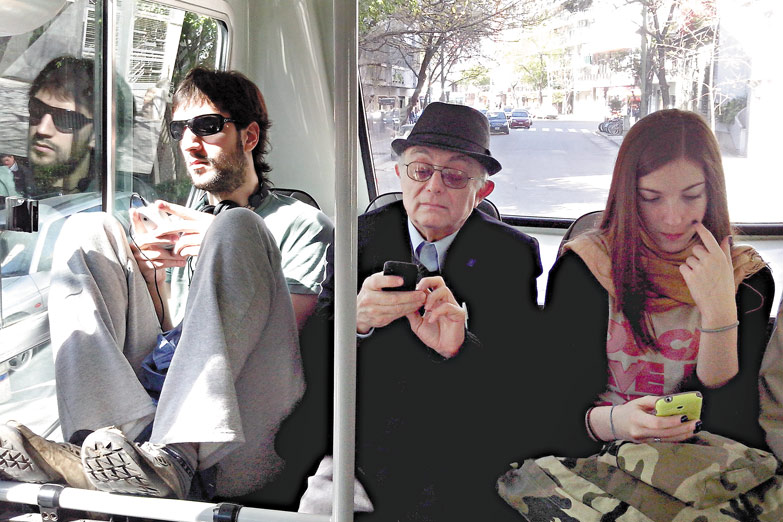

El tercer grupo está constituido por la cada vez más omnipresente cantidad de aparatos, superficies y entornos inmersivos e inteligentes con los que interactuamos día tras día: pantallas, dispositivos móviles y redes info-comunicacionales, muchos de los cuales incluyen la capacidad de aprendizaje automático antes mencionada. No hay aquí tanto una invención como un salto de escala. A diferencia de lo que podía ocurrir hace dos décadas, no tener hoy un teléfono celular no parece una opción: en 2015, la estadística del INDEC arrojó que en el país existía un parque de teléfonos móviles equivalente a 1,5 aparatos por persona. Según una consultora privada, en 2016 el 54% de los argentinos tenía un smartphone.

El cuarto acontecimiento inaudito ya no es una innovación propiamente dicha, sino el efecto de conjunto de la convergencia y la masividad de las redes informáticas, las telecomunicaciones y los distintos dispositivos de captura de datos. Se trata de la existencia y disponibilidad de los llamados Big Data: esto es, la descomunal cantidad de información disponible para el análisis y la correlación de estadísticas, y que incluye máquinas y programas que procesan la información y son capaces de aprender de los resultados. Acaso no se trate de un efecto colateral: basta recordar que Internet tiene un origen bélico, es decir, desde su inicio es una máquina de vigilancia que organiza el flujo de informaciones en operaciones rastreables y reversibles, ubicando a cada usuario bajo observación real o posible.

Esos datos incluyen las huellas que como usuarios dejamos en una red social o en un smartphone, ya sea que uno lo use para hablar, o porque está conectado a un programa con geolocalización como Waze, Tinder o Google Maps. También las compras con tarjeta, y la información que recogen los dispositivos instalados en hogares o lugares de trabajo, que monitorean desde el consumo de energía hasta la performance de los trabajadores. Incluso cómo uno mueve el mouse sobre una página de Internet puede quedar registrado. Toda esta información es almacenada por diferentes empresas (de telefonía, motores de búsqueda, redes sociales, agencias de vigilancia pública o privada, proveedores de Internet) y puede ser comprada y vendida con diferencias según las regulaciones de cada nación.

¿Quiénes usan estos datos? Los gobiernos los recolectan con fines de seguridad, controles internos, gestión de recursos, optimización de gastos; los científicos los usan para adquirir y mejorar conocimientos; los políticos, para influir en las campañas; las empresas, con fines de marketing y publicidad, para personalizar productos, para mejorar la gestión de stocks.

¿Cuánto dicen de nosotros esas huellas? Tomemos solo el caso de los rastros que dejamos en Facebook, una empresa de datos que tiene 1860 millones de usuarios activos por mes. Hace cinco años, el psicólogo Michal Kosinski, doctor en psicometría de la Universidad de Cambridge, demostró que, sobre la base de un promedio de 68 me gusta dejados por un usuario de Facebook, era posible predecir su color de piel (con 95% de precisión), su orientación sexual (88%) y su filiación política (85%). También podían determinarse su coeficiente intelectual, su religión, si usaba drogas o alcohol, e incluso si sus padres estaban separados. Luego fue capaz de predecir a una persona mejor que sus amigos sobre la base de 70 me gusta; 150 fueron suficientes para superar lo que sabían los sus padres; y 300 me gusta, lo que conocía su pareja. Según cuentan Hannes Grasseger y Mikael Krogerus en la revista suiza Das Magazin, el día en que Kosinski publicó estos hallazgos recibió dos llamadas telefónicas: una amenaza de demanda legal y una oferta de trabajo. Las dos de Facebook.

Todo esto implica, como es fácil entender, que junto con estos grandes datos ha emergido también una fabulosa capacidad de conocer de manera ajustada a la población se nos conoce, en efecto, con un nivel de detalle que la demografía tradicional jamás imaginó alcanzar. Creció así exponencialmente la capacidad de predecir los comportamientos, lo que incluye la posibilidad de dirigir mensajes personalizados el llamado microtargeting para intentar convencer a los usuarios de volverse clientes y, por qué no, votantes. Es en ese doble filo inquietante entre asistencia y facilitación, vigilancia y manipulación, que se juega nuestro futuro en relación con este cuarto campo de novedades.

TO BIT OR NOT TO BIT

¿Qué resonancias tienen estos procesos y acontecimientos en nuestros modos de actuar y autocomprendernos como individuos y como sociedades? Podemos mencionar algunas de las tendencias generales. Por un lado, respecto de cómo nos relacionamos con las inteligencias artificiales, hemos pasado del temor fascinado de la fase inicial a la dependencia despreocupada: aceptamos cada vez de mejor grado delegar en las máquinas las propias facultades (memoria, cómputo, planificación) y hasta podríamos considerar delegarles acciones que hasta hace poco eran vistas como estrictamente personales: cuidar, convencer, hacer compañía, imaginar qué le gustaría a otra persona (el film Her, de Spike Jonze, lleva al extremo esta imaginería).

Ese rumbo se sostiene sobre una premisa sospechosamente rígida: que el proceso es a la vez necesario e irreversible. El experto en sistemas alemán Martin Hilbert, asesor informático de la Biblioteca del Congreso de los EE UU, ilustró semanas atrás esta perspectiva en una entrevista a la revista The Clinic: Ya estamos fusionados con esta tecnología, como sociedad y como especie. Nuestra distribución de recursos ocurre básicamente en la Bolsa, y el 80% de las transacciones de la Bolsa son decididas por inteligencia artificial (IA). El 99% de las decisiones de la red de electricidad son tomadas por IA que localiza en tiempo real quién necesita energía. Y si tú me dices: Mira, Martin, descubrimos una especie donde un sistema que se llama IA distribuye el 80% de los recursos y el 99% de la energía, yo diría: Bueno, IA es una parte inseparable de esta sociedad. (…) Tú podrías irte a la Cordillera, dejar tu celular atrás y nunca más tener interacciones digitales, pero ya no serías parte de nuestra sociedad. Dejarías de evolucionar con nosotros.

Por otro lado, como señala David Lyon, pionero en los estudios sociales de la vigilancia, asistimos a una sutil pero decisiva mutación en lo que se refiere a la experiencia de estar siendo observados: estamos pasando de lo que los investigadores llamaban, hasta finales del siglo XX, sociedad de la vigilancia a una cultura de la vigilancia. Ya la primera implicaba que la vigilancia era una experiencia social generalizada, que involucraba agencias de gobierno, policía, espacios de trabajo, servicios de inteligencia y empresas de un modo cada vez más entrelazado. La idea de una cultura de vigilancia va aun más allá, buscando advertir que, sobre todo después de los atentados del 11S, la vigilancia se fue convirtiendo en un modo de vida, en la medida en que es parte de nuestra rutina cotidiana en aeropuertos y calles, en los teléfonos y en las redes. Desde esta perspectiva, la vigilancia no solo es algo que se les hace a las personas, sino algo en lo que ellas, quieran o no, participan cuando deciden aceptar términos y condiciones de un servicio o cuando se sacan una selfie y la suben a Instagram. Y que se asume muchas veces sin cuestionamientos, ya como aseguración (es conveniente que entre todos nos vigilemos) o como exhibición (si me pueden ver, ¡que me vean!).

En un tercer orden, las tecnologías también han facilitado que nos veamos a nosotros mismos como lo que el sociólogo británico Nikolas Rose llama individuos somáticos, es decir, como seres biológicos, hechos de cerebro, genes, hormonas, redes neuronales, antes que como compuestos cuerpo-alma o cuerpo-conciencia. Durante buena parte de los siglos XIX y XX, los seres humanos occidentales se comprendían como seres habitados por una interioridad psicológica profunda. Y organizaban su experiencia vital alrededor de un eje situado en su interioridad, en la que debían bucear para encontrar una verdad íntima y algo oscura. En las últimas décadas, esa figura empezó a ser desplazada por un ser inquieto por eventuales fallas genéticas, disturbios neuroquímicos, inadecuaciones estéticas, cuyo remedio ya no está en el recurso introspectivo sino en la acción consciente, responsable sobre el propio cuerpo. Para lo cual se espera que actuemos de una manera prudente y previsora, buscando anticiparnos al desencadenamiento de la enfermedad concreta, asumiendo la salud como un estado incierto (ya que nuestros cuerpos están siempre amenazados desde el interior por enfermedades potenciales) y, quizás, inalcanzable.

Finalmente, en nuestra relación con estos dispositivos de la conexión permanente, vemos debilitarse la diferenciación entre los momentos de ocio y de trabajo, así como advertimos que se desvanecen nuestros tiempos muertos cotidianos cuando ya no disponemos de un segundo para la distracción involuntaria: un viaje de tren o un rato en la plaza es ocasión que aprovechamos para la hipercomunicación. En esta nueva economía de la atención, estamos más conectados pero menos concentrados. Al cansancio y la irritabilidad, efectos conocidos del multitasking, se suman la tendencia al desapego (siempre hay algo o alguien más por hacer o conocer). Según nos advierte Jonathan Crary en su libro 24/7. El capitalismo tardío y el fin del sueño, incluso el sueño, esa anomalía hasta ahora irreductible a la forma mercancía, está siendo objeto de estudios para intentar reducirlo al mínimo. Mucho antes de saber si ese plan puede funcionar, ojalá seamos capaces de no aventurarnos en él.