«Mi equipo de Big Data analizó sus actividades» y los acusó de ser «empleados poco comprometidos e improductivos». Así comenzaba el email que recibió un viernes a la noche Nikolai, mientras intentaba disfrutar del comienzo del fin de semana. «Muchos pueden estar sorprendidos, pero realmente creo que Xsolla no es para ustedes», continuaba. De esta manera, Nikolai y otros 150 empleados se enteraron que desde el lunes no tenían más trabajo. La reducción de personal en Xsolla, una multinacional de origen ruso, con sede en Los Angeles, que brinda servicios de sistemas de pago a firmas de la industria de los juegos, no fue tomada por el departamento de recursos humanos. La recomendación la hizo un sistema de algoritmos, que catalogó a los cesanteados como «improductivos». El CEO y fundador de la firma, Alexander Agapitov, dijo no estar del todo de acuerdo con el algoritmo pues consideraba a los empleados «buenos profesionales», pero igual avanzó con la decisión porque, comentó, estaba obligado a hacerlo por protocolos internos consensuados con sus accionistas.

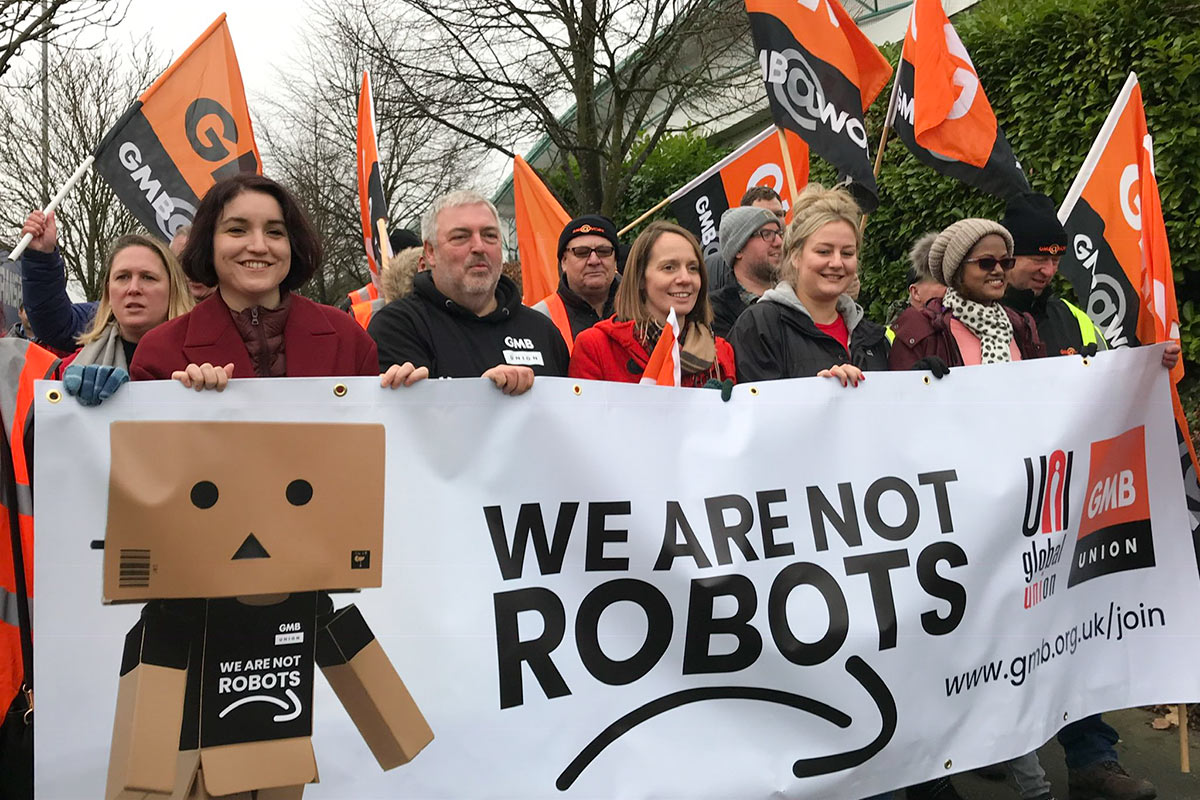

Xsolla no es la primera empresa en hacer esto y no será la última. A mediados de año, Amazon, el gigante tecnológico dedicado al comercio electrónico y una de las compañías que más fondos invierte en desarrollos de Inteligencia Artificial (IA), inició la moda de despedir repartidores de sus productos mediante un algoritmo.

Útil para tomar decisiones adecuadas en un sinfín de situaciones, la tecnología se transforma aquí en una herramienta para que nada cambie, y permite a sus ambiciosos dueños seguir incrementando sus ganancias. Pero el algoritmo no es inocente, no se gesta solo.

Un algoritmo es un conjunto ordenado y sistematizado de operaciones que permite hacer un cálculo y hallar la solución a algún problema. Desde luego, los parámetros que fijan esas operaciones siguen el criterio de los programadores que crean los algoritmos, y el de las empresas para las que trabajan.

“La inteligencia artificial (IA) más tradicional se basaba en reglas. Vos le decías al algoritmo explícitamente qué acción debía tomar ante una combinación de situaciones. En ese caso, el programa no podía aprender de los datos. Ahora, casi toda la IA se basa en un aprendizaje automático de esos datos”, explica a Tiempo Luciana Ferrer, ingeniera electrónica e investigadora adjunta del Conicet del Instituto de Ciencias de la Computación, que funciona en Exactas (UBA).

Esta herramienta tecnológica ya es parte de nuestras vidas y abarca prácticamente todos los campos: ocio, juegos, deportes, medicina, consumo de productos y servicios, y política. “Un ejemplo concreto de los tantos usos son las plataformas que pasan a texto los audios. Hay un trabajo intensivo previo de muchas horas de grabación del habla, y muchas trascripciones que diferentes personas realizaron a mano. El sistema aprende patrones de esos datos, y luego lo hace automáticamente”, cuenta Ferrer.

Los usos son infinitos. “En un call center, por ejemplo, hay programas que detectan en qué momento el cliente se empieza a enojar para que inmediatamente deriven la llamada a una persona. Por supuesto, los sistemas aún no son tan capaces de detectar todas las emociones como nosotros. Donde sí hubo avances muy importantes es en la medicina, que trata de facilitarle el trabajo al médico. La aplicación advierte sobre diferentes problemas para que el profesional sea el que termine de tomar una decisión. Por ahora se está muy lejos de poder reemplazar a un especialista médico”, puntualiza Ferrer.

El filósofo israelí Yuval Noah Harari fue uno de los primeros en plantear la necesidad de una ética y moral en el mundo de los programadores de algoritmos: “Tenemos que asegurarnos de que los diseñadores de estas herramientas que impulsan, por ejemplo, los vehículos autónomos, han aprendido a pensar éticamente”, afirmó. Pero los métodos implementados dentro de muchas compañías, en especial en las relacionadas con la tecnología, avanzan rápidamente en procesos de automatización que no cumplen con ésta premisa ética. Al contrario. Usarla para elegir a quién despedir va, claramente, en otra dirección.

“Yo creo que estamos muy avanzados en tecnología y muy atrasados en la regulación de su uso. Estamos aplicando muy rápidamente estas herramientas, que no funcionan lo suficientemente bien y que tampoco terminamos de entender bien cómo funcionan. El problema es que los algoritmos aprenden de los sesgos de quienes cargaron esos datos. No hay manera de deshacer eso”, agrega Ferrer. Varias empresas dedicadas a la IA han procurado que los algoritmos eviten esos sesgos. Pero si la propia firma pide al programador que el algoritmo sea inflexible en la detección del empleado «descartable», no hay ética posible.

Son muchos los ejemplos de utilización del algoritmo: “Los autos que se conducen por sí solos y que se equivocan menos que los humanos. O los programas asistentes para el aprendizaje, que todavía no reemplazan a los profesores –enumera Ferrer–. Ahora bien, un programa no puede ocupar el rol de un funcionario judicial, ni tampoco decidir quién es más capaz para tal o cual trabajo. Estamos abusando de la capacidad que tienen las aplicaciones. En muchas ocasiones me he negado a realizar un trabajo porque no me parecía ético, pero tampoco es la solución, debe haber leyes que regulen el sector”.

El rol de las plataformas y los algoritmos en la creación de la realidad es hoy un tema de estudio crucial en el campo de las ciencias sociales. Cuántas veces, al sondear las características de un producto en la web, segundos más tarde las redes nos ofrecen productos similares. O posteamos sobre un determinado político e inmediatamente después aparece en nuestro scroll de Facebook un candidato de ese espacio. En las redes, en plataformas de entretenimientos como Netflix o de compras como MercadoLibre, el algoritmo discrimina, segmenta, cuantifica, ordena y genera opciones para cada perfil de usuario. Esto, ¿afecta la toma de decisiones? ¿Con qué herramientas de autodefensa contamos?

“Tenemos que hacer un entrenamiento propio e intentar ver las otras cosas que están dando vueltas y que el algoritmo no nos muestra, porque la posibilidad técnica de hacer eso existe, y podemos romper con la burbuja algorítmica que se nos presenta”, razona en diálogo con Tiempo el sociólogo Martín Gendler, becario doctoral del Conicet en el Instituto de Investigaciones Gino Germani.

Para el especialista, que dedicó varios trabajos al estudio de la «gubernamentalidad algorítmica», el algoritmo está regido por sesgos que los humanos introducen en su base de datos: “Esto determina que el algoritmo no sea neutral ni objetivo y que esté gobernado por el hombre. Y cuando esta herramienta recopila datos, es fundamental que ese código esté auditado y abierto. Es decir, democratizar el algoritmo es una de las cuestiones más fundamentales que tenemos hoy en día, porque si son pocas empresas privadas las que concentran todos los flujos y nuestra actividad digital, y éstas no ponen a disposición sus códigos de algoritmos, ya no alcanza con que los Estados tengan conocimiento de esos datos, sino la sociedad civil toda y los organismos de derechos humanos”, subraya.

Contrariamente a lo que sintetiza el sentido común, los algoritmos digitales no manipulan nuestros gustos. “Lo que hacen es reforzar nuestras decisiones. Son raros los casos donde la burbuja algorítmica te muestra algo que no tiene que ver con uno, porque se va nutriendo de nuestros gustos –plantea Gendler–. Si alguien de derecha ‘clickea’ sobre determinado candidato, el algoritmo desprecia al resto, lo oculta cada vez más. Y es ahí cuando uno termina pensando que existe solo una de las dos campanas, y eso a nivel de efectos democráticos, tiene sus consecuencias”.

Algoritmos nutricionales para alimentarse mejor

La semana pasada, la revista especializada Nature publicó en su sección Nature Foood una nueva tabla nutricional que clasifica los alimentos del mejor al peor, según sus beneficios para la salud humana. Un equipo de la Escuela Friedman de Ciencias y Políticas de Nutrición, de la Universidad Tufts, de Boston (Estados Unidos), desarrolló Food Compass, un algoritmo nutricional con una gran base de datos, con el objetivo de ser usado para los etiquetados de productos, el sector público y restaurantes. La plataforma fue desarrollada de acuerdo a un listado de más de 8000 alimentos y bebidas y es uno de tantos ejemplos del buen uso de la teoría de algoritmos en la industria y el consumo. Cada producto recibe una puntuación final que oscila entre 1 (menos saludable) y 100 (más saludable). Los investigadores identificaron con 70 o más puntos los alimentos o bebidas que deben fomentarse; aquellos con una puntuación de 31-69 deben consumirse con moderación; y cualquier producto que tenga 30 puntos o menos debe consumirse mínimamente.

Ecosistema digital y democracia

Hace dos semanas, la caída de diferentes plataformas digitales de la red social Facebook, la megaempresa que maneja Instagram y WhatsApp -entre otras 40 firmas fusionadas-, dejó en evidencia que ésta “ocupa una gran parte del ecosistema de plataformas, por eso se sintió el golpe cuando colapsaron sus tres redes más importantes”, introduce Martín Gendler. El especialista advierte que esa caída produjo un efecto cascada en el resto de las plataformas, “porque los usuarios, al caerse WhatsApp, se pasaron a Telegram, y colapsó esa red. Lo mismo ocurrió con Twitter o Tik Tok. Esto nos muestra que es un ecosistema muy interconectado y que de tres millones de plataformas existentes, los usuarios terminan manipulando poco más de diez. Esto es un claro ejemplo de por qué hay que repensar la democratización en internet y de la necesidad de abrir los algoritmos digitales”, termina.